網管人雜誌

本文刊載於 網管人雜誌第 157 期 - 2019 年 2 月 1 日出刊,NetAdmin 網管人雜誌 為一本介紹 Trend Learning 趨勢觀念、Solution Learning 解決方案、Technology Learning 技術應用的雜誌,下列筆記為本站投稿網管人雜誌獲得刊登的文章,網管人雜誌於每月份 1 日出刊您可於各大書店中看到它或透過下列圖示連結至博客來網路書店訂閱它。文章目錄

前言SMS 基礎運作架構

SMS 遷移工作流程

SMS 安全性需求

實戰 SMS 遷移機制

前置作業、準備 WAC 及協調流程伺服器

SMS 遷移步驟 1、建立 SMS 遷移工作任務

SMS 遷移步驟 2、傳輸資料至目的地伺服器

SMS 遷移步驟 3、目的地伺服器接手電腦帳戶及 IP 位址

驗證是否順利接手

結語

前言

雖然,微軟最新 Windows Server 2019雲端系統已經於 2018 年 10 月正式發佈,但是由業界知名的 Spiceworks 網站統計結果來看,企業及組織中仍舊有許多 Windows Server 2003 R2、Windows Server 2008 R2、Windows Server 2012 R2……等作業系統還在服役中(如圖 1 所示)。請注意!! Windows Server 2003 R2作業系統延伸支援服務早已經於 2015 年 7 月 14 日結束支援,而 Windows Server 2008 R2作業系統也預計於 2020 年 1 月 14 日結束支援。

圖 1、企業及組織地端資料中心內採用的作業系統比例示意圖

因此,企業及組織中的 IT 管理人員,或許對於 Windows Server 2019 雲端作業系統新增的各項特色功能或增強機制感到滿意並希望能夠嘗試導入,但是如何將舊有作業系統輕鬆且快速移轉至 Windows Server 2019 雲端作業系統上繼續運作,卻往往令 IT 管理人員頭痛不已甚至卻步。

本文將深入剖析及實作演練,期望幫助 IT 管理人員能夠輕鬆透過 SMS(Storage Migration Service)遷移機制,將 Windows Server 2003 R2、Windows Server 2008 R2、Windows Server 2012 R2……等舊有作業系統,轉移至新式 Windows Server 2016 或 Windows Server 2019 雲端作業系統中,而無須再花費心力維護老舊失修的作業系統。

SMS 基礎運作架構

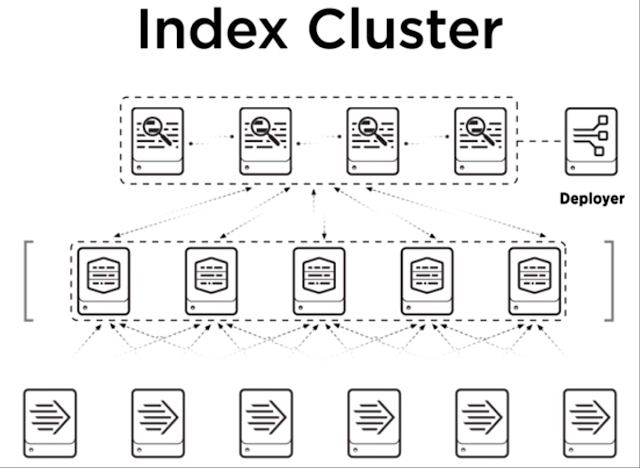

在開始使用 SMS(Storage Migration Service)遷移機制之前,我們必須先了解整個 SMS 機制的基礎運作架構,才能讓後續的遷移作業得以順利且快速的移轉完成。在 SMS 基礎運作架構中,將有 4 個工作角色分別是「Source Server、Destination Server、Orchestrator Server、Windows Admin Center」:

- Source Server:來源端伺服器,也就是管理人員希望進行「遷移」(Migrate)工作任務的舊有主機,支援的作業系統版本為 Windows Server 2003 / 2003 R2 / 2008 / 2008 R2 / 2012 / 2012 R2 / 2016 / 2019 。

- Destination Server:目的地伺服器,通常是管理人員希望移轉工作任務的新版主機,支援的作業系統版本為Windows Server 2012 R2 / 2016 /2019。一般來說目的地伺服器的 Windows Server 作業系統版本通常較新,但 SMS 機制也支援來源端伺服器採用新版 Windows Server 2019 作業系統版本,遷移至 Windows Server 2012 R2 / 2016 相較之下較舊的作業系統版本,只是必須要注意的是雖然遷移後應用程式或服務仍可正常運作,但是執行效能可能會減少 50% 。

- Orchestrator Server:協調流程伺服器,必須運作在 Windows Server 2019 作業系統版本中,倘若遷移工作任務繁多時建議採用單獨的協調流程伺服器以確保遷移流程順暢無誤。

- Windows Admin Center:WAC 管理主控台,管理人員必須在 WAC 管理頁面中安裝及啟用 SMS 機制,值得注意的是必須採用 WAC 1809 或後續版本才支援安裝及啟用 SMS 遷移機制。

圖 2、SMS 遷移機制基礎運作架構示意圖

SMS 遷移工作流程

了解上述 SMS 機制 4 種不同的工作角色之後,接著便是了解整個 SMS 遷移工作流程。事實上, SMS 遷移流程非常簡要快速並且只需要下列 3 項工作任務流程即可:- Inventory Servers:當管理人員為 WAC 管理主控台安裝及啟用 SMS 遷移機制後,便可以執行「Add and scan devices」的動作,也就是告訴 SMS 遷移機制準備轉換的「來源端伺服器」(Source Server)是哪台主機,指定後 SMS 遷移機制便會進行掃描作業,例如,該台來源端伺服器有幾個磁碟機、磁碟機儲存空間大小、磁碟機儲存空間使用情況 …… 等。完成來源端伺服器的掃描及檢查作業後,接著針對「目的地伺服器」(Destination Server)進行 SMS 遷移機制掃描作業,例如,確認該台目的地伺服器有幾個磁碟機、磁碟機儲存空間大小、磁碟機儲存空間使用情況……等。

- Transfer(Copy):由於在上一個工作流程中 SMS 遷移機制,已經掃描及檢查完成來源端伺服器及目的地伺服器的儲存資源結構,所以在這個工作流程中將開始針對來源端伺服器,將指定的檔案「傳輸/複製」(Transfer / Copy)至目的地伺服器中。

- Cut over to the new servers:這是 SMS 遷移機制的最後一項工作流程,當完成由來源端伺服器傳輸複製檔案至目的地伺服器後,此時 SMS 遷移機制會進行由目的地伺服器接管來源端伺服器的動作,也就是由目的地伺服器接手來源端伺服器在 Windows 網域中的「電腦帳戶」(Computer Account)及「IP 位址」(IP Address),以便使用者端能夠無須更改任何組態設定便可以直接存取原有的服務,並且 SMS 遷移機制在確認目的地伺服器接手作業完成後,會將來源端伺服器進入維護狀態。

SMS 安全性需求

在 SMS 遷移機制運作架構及工作流程中,必須進行檔案傳輸複製作業以及電腦帳戶和 IP 位址的接管作業。因此,管理人員在實作前務必要滿足來源端伺服器及目的地伺服器的相關安全性需求:- 管理者帳號權限:由於屆時目的地伺服器將會接手原本來源端伺服器的電腦帳戶,因此管理人員除了必須具備來源端及目的地伺服器的管理者帳號權限之外,當然也必須擁有 Windows 網域管理權限才行。

- 協調流程伺服器:擔任協調流程伺服器角色的主機,必須在主機防火牆規則中啟用「Inbound – File and Printer Sharing(SMB-In)」並允許相關網路流量能夠通過。雖然,當 Windows Server 2019 主機安裝 Storage Migration Service Proxy Service 後,系統便會自動為 Windows Server 2019 主機開啟該防火牆規則,但是管理人員應該在安裝服務完成後再次檢查確認防火牆規則是否開啟,以避免屆時 SMS 遷移作業因為防火牆規則未正確運作產生錯誤而中斷遷移作業。

- 來源端 / 目的地伺服器:管理人員在進行 SMS 遷移作業之前,必須確保來源端 / 目的地伺服器是否已經啟用「File and Printer Sharing(SMB-In)、Netlogon Service(NP-In)、Windows Management Instrumentation(DCOM-In)、Windows Management Instrumentation(WMI-In)」防火牆規則並放行相關網路流量,否則將會影響屆時的 SMS 遷移作業。

- 處於同一網域:雖然,在技術上可以達成跨網域進行 SMS 遷移作業,但是在進行接手作業時來源端伺服器與目的地伺服器,仍必須處於「同一網域」運作環境中才能夠順利進行切換及接手作業。

實戰 SMS 遷移機制

了解 SMS 遷移機制的運作架構、工作原理、安全性需求後,那麼我們便可以實作演練 SMS 遷移機制。在本文實作演練環境中,我們將一台原本由 Windows Server 2012 R2伺服器主機運作的 IIS 網頁服務(來源端伺服器),透過 SMS 遷移機制將 IIS 網頁相關檔案傳輸及複製至 Windows Server 2019 主機(目的地伺服器),然後進行電腦帳戶及 IP 位址的接手作業,最後由使用者端驗證是否無須進行任何修改便能存取由新的 Windows Server 2019 主機,存取原本由 Windows Server 2012 R2 主機所提供的 IIS 網頁服務。前置作業、準備 WAC 及協調流程伺服器

在開始進行來源端 / 目的地伺服器的 SMS 遷移工作任務之前,我們先準備 WAC 管理主控台及協調流程伺服器,由於本文為小型的 SMS 遷移機制實作演練環境。因此,由「同一台」Windows Server 2019 主機,同時擔任 WAC 管理主控台及協調流程伺服器的角色。實務上,倘若 SMS 遷移工作任務繁多時,建議採用單獨的協調流程伺服器以確保遷移流程工作效率。

首先,請為 Windows Server 2019 主機安裝目前最新的「Windows Admin Center 1809」版本,安裝作業完成後請確認 Windows Server 2019 系統服務中,是否多出「Windows Admin Center」項目並且為「Running」的運作狀態(如圖 3 所示),同時 Windows Server 2019 主機是否也開啟 WAC 預設採用的「Port 443」連接埠。

有關 Windows Admin Center 安裝及使用的詳細資訊,請參考本刊《 第 153 期–新版 WAC 免費易用輕鬆管理主機和容錯移轉叢集 》。

圖 3、WAC 安裝完成後 Windows Server 2019 主機是否運行 Windows Admin Center 系統服務

確認 Windows Server 2019 主機,順利安裝及運行 Windows Admin Center 系統服務後,便可以透過瀏覽器登入 WAC 管理介面,並請切換到 Windows Admin Center 設定中 Extensions 頁面,確認是否有「Windows Server Storage Migrations Service」項目(如圖 4 所示)。

請注意!! 必須採用最新釋出的 Windows Admin Center 1809或後續版本,才支援使用 Storage Migrations Service。

圖 4、確認是否有 Windows Server Storage Migrations Service 擴充模組項目

確認具備 Windows Server Storage Migrations Service 擴充模組後,請依序點選「Server Manager > WAC Host > Storage Migration Service」項目,然後按下 Install 鈕為該台 Windows Server 2019 主機安裝 Storage Migration Service ,安裝作業完成後便能夠看到 Storage Migration Service 儀表板內容,例如,Inventory、Transfer、Cutover 等相關工作任務數量(如圖 5 所示)。

圖 5、為 Windows Server 2019 主機安裝 Storage Migration Service

SMS 遷移步驟 1、建立 SMS 遷移工作任務

在開始進行 SMS 遷移工作任務之前,倘若你的「目的地伺服器」為 Windows Server 2019 作業系統版本的話,請為 Windows Server 2019 主機安裝「Storage Migration Service Proxy」伺服器功能,因為此舉可以讓屆時 SMS 遷移工作流程中,在進行傳輸及複製檔案作業時有效縮短至少「50 %」的傳送時間。請在 Windows Server 2019 主機中開啟伺服器管理員,然後依序點選「Manage > Add Roles and Features > Features」項目後,勾選「Storage Migration Service Proxy」伺服器功能項目進行安裝(如圖 6 所示)。

圖 6、為目的地伺服器安裝 Storage Migration Service Proxy 伺服器功能以加快傳輸速度

在新增 SMS 遷移工作任務之前,請再次確認來源端 / 目的地伺服器是否已經啟用及放行下列 4 項防火牆規則,否則稍後的 SMS 遷移工作任務將會因為被防火牆阻擋而發生錯誤造成遷移作業中斷:

- File and Printer Sharing(SMB-In)

- Netlogon Service(NP-In)

- Windows Management Instrumentation(DCOM-In)

- Windows Management Instrumentation(WMI-In)

請切換到 WAC 管理主控台的 Storage Migration Service 頁面中,按下「New job」建立 SMS 遷移工作任務並給予名稱,在本文實作環境中建立的工作任務名稱為「WS2012IISto2019」,在「Enter credentials」頁面中,請鍵入具備「來源端伺服器」管理者權限的使用者帳號及密碼後按下 Next 鈕。

在「Add and scan devices」頁面中,請按下「Add a device」後鍵入「來源端伺服器」的主機名稱,本文實作環境來源端伺服器主機名稱為「WS2012-IIS」,然後按下「Start scan」鈕進行來源端伺服器的掃描及檢查作業,並於掃描及檢查作業結束後歸類出「Shares、Configuration、Network adapters、Volumes」等 4 大項目(如圖 7 所示),讓管理人員能夠確認待遷移的來源端伺服器相關資訊是否正確。

圖 7、針對來源端伺服器進行掃描及檢查作業

SMS 遷移步驟 2、傳輸資料至目的地伺服器

完成來源端伺服器的資源掃描及檢查作業後,便可以進入 SMS 遷移工作任務的第 2 個步驟。首先,在 Transfer data 步驟 2 的「Enter credentials」頁面中,請鍵入具備「目的地伺服器」管理者權限的使用者帳號及密碼後按下 Next 鈕。在「Add a destination device and mappings」頁面中,請鍵入「目的地伺服器」的主機名稱,本文實作環境目的地伺服器主機名稱為「WS2019-IIS」,然後按下「Scan device」鈕進行目的地伺服器的掃描及檢查作業,當掃描及檢查作業完成後將會出現來源端 / 目的地伺服器的 Volume 資訊,此時管理人員可以選擇準備將來源端伺服器中的哪個磁碟區,傳輸資料至目的地伺服器中的哪個磁碟區。

在「Adjust settings」頁面中,可以調整屆時傳輸作業的相關組態設定值,例如,最大傳輸時間為 10080 秒、傳輸作業失敗時的重新嘗試次數……等。

在「Validate devices」頁面中,請按下「Validate」鈕讓 SMS 遷移服務再次檢查相關組態設定值及運作環境參數是否正確,包括,來源端 / 目的地伺服器是否能順利使用 SMB 連線、目的地伺服器是否安裝 Storage Migration Service Proxy 伺服器功能……等,管理人員可以按下 Validation 欄位中的「Pass」圖示查看驗證項目詳細資訊(如圖 8 所示)。

圖 8、SMS 遷移服務再次檢查相關組態設定值及運作環境參數是否正確

在「Start the transfer」頁面中,管理人員便可以按下「Start transfer」鈕將相關檔案由來源端伺服器傳輸至目的地伺服器,管理人員可以看到來源端 / 目的地伺服器的檔案數量、傳輸檔案開始和結速時間……等資訊(如圖 9 所示)。倘若,管理人員希望了解整個傳輸檔案的細節,可以按下「Transfer detail」鈕下載傳輸資訊 CSV 檔案,內容包括此次傳輸作業的檔案清單、檔案名稱、檔案路徑……等資訊。

圖 9、將相關檔案由來源端伺服器傳輸至目的地伺服器

SMS 遷移步驟 3、目的地伺服器接手電腦帳戶及 IP 位址

待資料傳輸作業完成後便進入 SMS 遷移工作任務的最後階段,由目的地伺服器接手來源端伺服器的電腦帳戶及 IP 位址。首先,在「Enter credentials」頁面中,請鍵入具備「目的地伺服器」管理者權限的使用者帳號及密碼後按下 Next 鈕。在「Configure cutover」頁面中,左側的「Source network adapters」將會顯示來源端伺服器的網路卡及 IP 位址資訊(本文實作環境為 10.10.75.12),在下方則是屆時目的地伺服器接手來源端伺服器的 IP 位址後所使用的新 IP 位址為何,在本文實作環境中指定新的 IP 位址採用「DHCP」,至於右側的「Destination network adapters」則是目的地伺服器所要使用的網路卡及目前使用的 IP 位址(本文實作環境為 10.10.75.19)。

至於 Configure cutover 頁面下方的「Rename the source device after cutover」區塊中,則是針對來源端伺服器屆時被目的地伺服器接手後所要採用的新電腦帳戶名稱為何,預設值「Use randomly generated name for source computer」選項,則是由 SMS 遷移機制為來源端伺服器隨機產新一個新的電腦帳戶,或是管理人員可以選擇「Choose a new name for source computer」選項,自行鍵入來源端伺服器屆時新電腦帳戶名稱,本文實作環境便是選擇此項目並鍵入新的電腦名稱為「WS2012-IIS-Orig」(如圖 10 所示)。

圖 10、準備來源端 / 目的地伺服器的電腦帳戶及 IP 位址接手資訊

在「Adjust settings」頁面中,可以調整屆時電腦帳戶及 IP 位址接手作業的組態設定值,預設接手作業的逾時時間為「2880 分鐘」。

在「Validate devices」頁面中,請按下「Validate」鈕讓 SMS 遷移服務再次檢查相關組態設定值及運作環境參數是否正確,包括,是否能夠順利連接至來源端 / 目的地伺服器、模擬測試目的地伺服器是否能接手來源端伺服器……等,管理人員可以按下 Validation 欄位中的「Pass」圖示查看驗證項目詳細資訊(如圖 11 所示)。

圖 11、SMS 遷移服務再次檢查相關組態設定值及運作環境參數是否正確

在「Start the cutover」頁面中,管理人員便可以按下「Start cutover」鈕進行接手作業,整個由來源端伺服器切換到目的地伺服器的流程如下:

- 重新啟動來源端伺服器。

- 變更來源端伺服器電腦帳戶及 IP 位址。

- 再次重新啟動來源端伺服器以便套用生效。

- 重新啟動目的地伺服器。

- 接手原本來源端伺服器的電腦帳戶及 IP 位址。

- 再次重新啟動目的地伺服器以便套用生效。

.

由上述接手作業流程可以看到,來源端伺服器及目的地伺服器分別都會「重新啟動 2 次」,並且當接手作業完成後原本的來源端伺服器便會採用新的電腦帳戶及 IP 位址,而原本的目的地伺服器將會接手來源端伺服器的電腦帳戶及 IP 位址(如圖 12 所示)。

圖 12、目的地伺服器接手來源端伺服器的電腦帳戶及 IP 位址

驗證是否順利接手

順利由 Windows Server 2019 主機,接手原本運作在 Windows Server 2012 R2 主機上的 IIS 網頁服務後,由於連同 Windows Server 2012 R2 主機的電腦帳戶及 IP 位址也一併接手,所以使用者無須進行任何額外的組態設定便能夠存取到原本的 IIS 網頁服務(如圖 13 所示)。圖 13、Windows Server 2019 主機順利接手原本 Windows Server 2012 R2 的 IIS 網頁服務