網管人雜誌

本文刊載於

網管人雜誌第 150 期 - 2018 年 7 月 1 日出刊,

NetAdmin 網管人雜誌為一本介紹 Trend Learning 趨勢觀念、Solution Learning 解決方案、Technology Learning 技術應用的雜誌,下列筆記為本站投稿網管人雜誌獲得刊登的文章,網管人雜誌於每月份 1 日出刊您可於各大書店中看到它或透過下列圖示連結至博客來網路書店訂閱它。

前言考量 Windows vCenter Server 遷移至 vCSA 管理平台 Embedded 部署模式遷移至 vCSA External 部署模式遷移至 vCSA vCenter Server 5.5 無法遷移至新版 vCSA 6.7實戰 - Windows vCenter Server 6.0 遷移至 vCSA 6.7 管理平台 執行 VMware Migration Assistant 遷移階段 1、部署 vCSA 6.7 虛擬主機 遷移階段 2、匯出 / 匯入 vCenter Server 資料庫及組態設定 採用 HTML5 或 FLEX 管理介面? VAMI 和 Clarity UI 提供良好 vCSA 管理體驗結語前言

VMware 官方在 2018 年 4 月 17 日時,正式推出新一代 SDDC 軟體定義資料中心解決方案

VMware vSphere 6.7版本。同樣的,整個 VMware vSphere 虛擬化基礎架構中,相關重要的運作元件及各式平台也同步推升至 6.7 版本,包括 vSphere ESXi 6.7 虛擬化平台、vCenter Server 6.7 管理平台、vSAN 6.7 軟體定義儲存、VMware Cloud on AWS 混合雲解決方案……等(如圖 1 所示)。

圖 1、VMware vSphere 6.7 Hybrid Cloud 運作示意圖

值得注意的是,隨著新一代管理平台 vCenter Server 6.7 版本的釋出,VMware 也在官方部落格中正式宣佈,在 vSphere 6.7 版本中的

vCenter Server for Windows管理平台,將會是「

最後一版」的 Windows vCenter Server 版本,這表示在後續的 vSphere 版本中,VMware 將只會釋出採用

SUSE Linux作業系統,所打造的

vCSA(vCenter Server Appliance)管理平台(如圖 2 所示)。

圖 2、vSphere 6.7 將是最後一版包含 vCenter Server for Windows 的版本

那麼,企業或組織當中的 VMware vSphere 管理平台,倘若已經建構在 Windows Server 作業系統平台上,是否有方式可以將現有 Windows vCenter Server 管理平台中的資料,例如,資料庫檔案、VM 虛擬主機效能資訊、vSwitch 虛擬交換器組態設定……等,無縫式的遷移至 VMware 官方所建議的 vCSA(vCenter Server Appliance)管理平台上呢?

本文所要說明及實作的重點,便是著重於如何將企業及組織中「

現有」的 Windows vCenter Server,無縫式的遷移至新一代的 vCSA 6.7 管理平台當中。

考量 Windows vCenter Server 遷移至 vCSA 管理平台

首先,管理人員必須要先確認,現有的 Windows vCenter Server 運作版本及部署模式,是早期的

5.5 版本還是較新的

6.x(6.0 或 6.5)版本,部署模式為採用所有運作角色 All-in-One 的「

Embedded」模式,還是各種角色分散運作的「

External」模式。

當管理人員確認 Windows vCenter Server 運作版本及部署模式後,那麼才能夠確認後續要執行遷移至 vCSA 管理平台的操作步驟有哪些(如圖 3 所示)。

圖 3、Windows vCenter Server 遷移至 vCSA 管理平台步驟示意圖

Embedded 部署模式遷移至 vCSA

當管理人員確認原有的 Windows vCenter Server 部署模式,為所有運作角色集中運作於「

同 1 台」主機上的「

Embedded」模式時,那麼只要執行 2 個遷移步驟(Migration Assistant 及 Migration Tool),即可完成遷移至 vCSA 管理平台的工作任務。

值得注意的是,從 VMware vSphere 6.0 版本開始,擔任 vSphere 虛擬化基礎架構管理平台角色的 vCenter Server,運作架構由早期

vSphere 5.x 版本四大角色

Inventory Service、Web Client、SSO(Single Sign-On)、vCenter Server,從新版

vSphere 6.0開始統一為

PSC(Platform Services Controller)及 vCenter Server這二大角色而已。

因此,倘若採用的是

vCenter Server 5.5管理平台時,那麼遷移至新版 vCSA 6.5 管理平台後,將會轉為使用新版 PSC(Platform Services Controller)運作架構。倘若採用的是

vCenter Server 6.0管理平台時,那麼除了原有 PSC 運作架構之外最大的不同便是底層的作業系統,由 Windows Server 遷移至 vCSA 管理平台所採用的 SUSE Linux 作業系統(如圖 4 所示)。

圖 4、Embedded 部署模式- vCenter Server 5.5 及 6.0 遷移至 vCSA 管理平台示意圖

External 部署模式遷移至 vCSA

倘若原有的 Windows vCenter Server 部署模式,為運作角色分散於「

不同台」主機上的「

External」模式時。那麼,當運作架構採用早期

vCenter Server 5.5版本四大角色

Inventory Service、Web Client、SSO(Single Sign-On)、vCenter Server 的話,就必須先透過 Migration Assistant 遷移工具,將 SSO(Single Sign-On)運作角色遷移至新版 PSC(Platform Services Controller)當中,然後再將其它三大角色 Inventory Service、Web Client、vCenter Server 進行遷移作業。

同樣的,採用的是

vCenter Server 6.0管理平台時,最大的不同便是底層的作業系統,由 Windows Server 遷移至 vCSA 管理平台所採用的 SUSE Linux 作業系統(如圖 5 所示)。

圖 5、External 部署模式- vCenter Server 5.5 及 6.0 遷移至 vCSA 管理平台示意圖

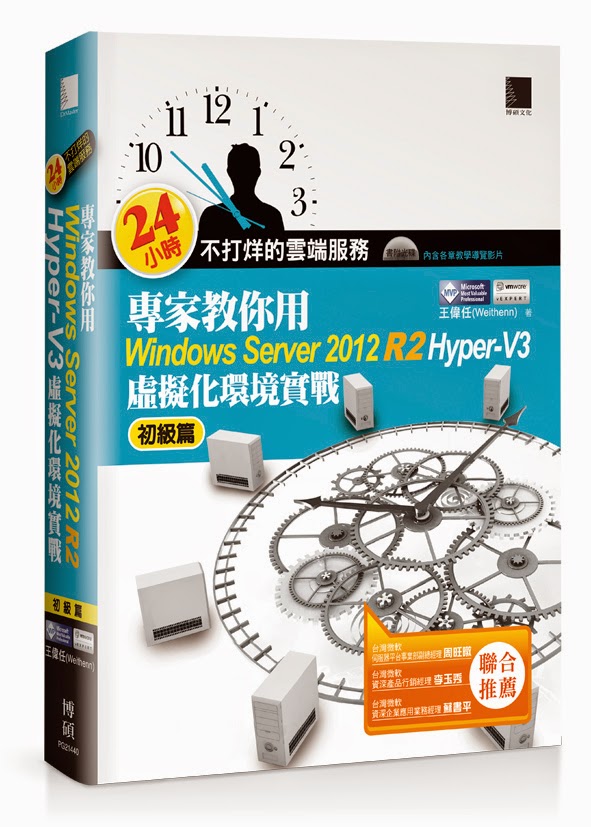

vCenter Server 5.5 無法遷移至新版 vCSA 6.7

此外,管理人員除了必須確認原有的 Windows vCenter Server 管理平台,採用的是 Embedded 或 External 部署模式之外,還必須注意 Windows vCenter Server 管理平台的「

版本」才行。

因為,當企業或組織採用的是舊版 Windows vCenter Server 5.5 管理平台時,將「

無法」直接遷移至

最新版本 vCSA 6.7管理平台,必須先遷移至 vCSA 6.0 或 vCSA 6.5 版本的管理平台後,才能升級至新版 vCSA 6.7 管理平台。

當然,若企業或組織採用的是

Windows vCenter Server 6.0或 6.5版本的管理平台時,不管採用的是 Embedded 或 External 部署模式,都可以直接遷移至最新版本

vCSA 6.7管理平台(如圖 6 所示)。

圖 6、Windows vCenter Server 6.0 或 6.5 版本可直接遷移至新版 vCSA 6.7

實戰 - Windows vCenter Server 6.0 遷移至 vCSA 6.7 管理平台

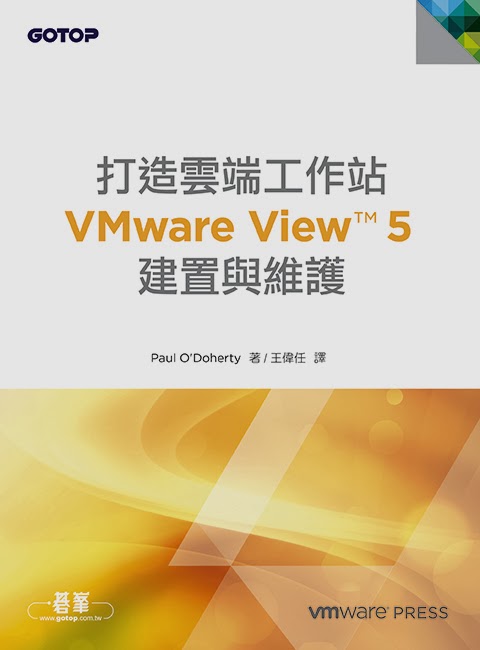

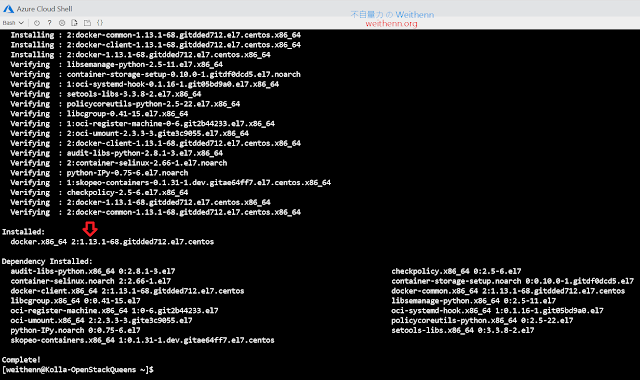

在本文實作環境中,我們採用已經建置好的

Windows vCenter Server6.0版本,並且受管理的虛擬化平台也採用

vSphere ESXi 6.0版本(如圖 7 所示)。同時,在建置 Windows vCenter Server 6.0 管理平台時,採用的是所有運作角色集中於同 1 台主機的「

Embedded」模式,稍後將逐步實作遷移至新版

vCSA 6.7管理平台。

圖 7、現有 Windows vCenter Server 6.0 管理平台運作環境

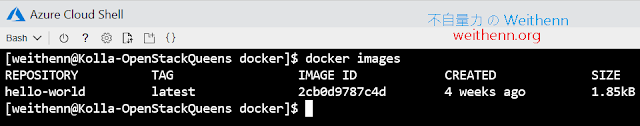

執行 VMware Migration Assistant

首先,必須在「

來源端」vCenter Server 主機上執行 VMware Migration Assistant 遷移工具,在本文實作環境中便是在 Windows vCenter Server 6.0 主機上執行。

請在 Windows vCenter Server 6.0 主機上,掛載 vCSA 6.7 ISO 映像檔之後,執行「

D:\migration-assistant\VMware-Migration-Assistant.exe」遷移工具執行檔(本文實作環境光碟機為 D 槽)。

此時,VMware Migration Assistant 遷移工具,將會檢查此台 Windows vCenter Server 運作環境是否能執行遷移作業,舉例來說,在遷移工作任務中會使用

C Runtime功能,所以倘若 Windows Server 未具備這樣的運作環境時,則會提醒應該安裝相關 KB 後再次執行。在本文實作環境中,遷移工具便提示應該

安裝 KB 2999226之後(如圖 8 所示),再次執行 VMware Migration Assistant 遷移工具。

圖 8、VMware Migration Assistant 遷移工具將預先檢查是否能執行遷移作業

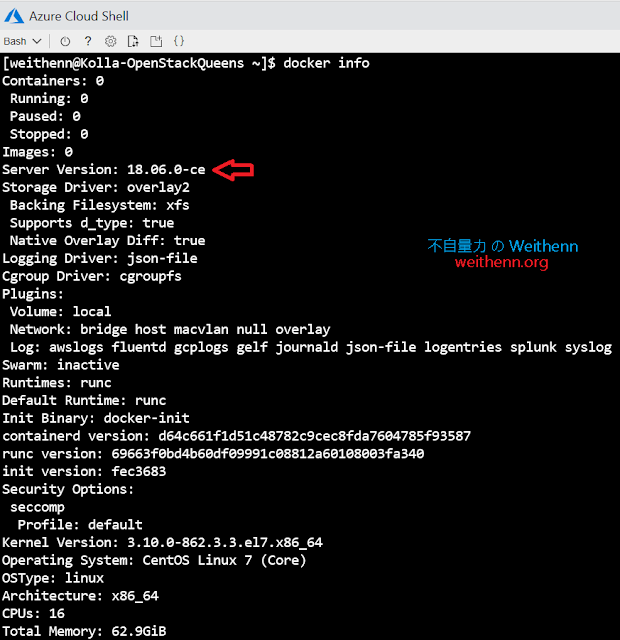

Windows vCenter Server 遷移環境準備好之後,再次執行 VMware Migration Assistant 遷移工具,系統將會請你鍵入

預設 Administrator@vsphere.local管理者帳號的密碼,通過身分驗證程序後便正式進行遷移流程環境檢查作業。

此時,VMware Migration Assistant 遷移工具將會顯示相關資訊,例如,來源端 vCenter Server 版本(本文實作環境為 Windows vCenter Server 6.0)、目的端 vCenter Server 版本(本文實作環境為 vCSA 6.7)、遷移組態設定(本文實作環境 vCenter Server 的 FQDN 為 vCenter.vsphere.weithenn.org)、遷移步驟……等(如圖 9 所示)。

圖 9、VMware Migration Assistant 遷移工具運作環境檢測完畢

當 VMware Migration Assistant 遷移工具檢測完畢後,將會顯示「

Waiting for migration to start...」資訊。此時,管理人員便可以執行遷移 vCenter Server 的下一項工作任務,透過 VMware Migration Tools 開始遷移資料。

遷移階段 1、部署 vCSA 6.7 虛擬主機

當來源端的 Windows vCenter Server 6.0 管理平台完成遷移檢測後,請在 vSphere 虛擬化環境中「

另一台」工作站主機掛載 vCSA 6.7 ISO 映像檔,同時這台工作站主機必須要能夠存取 Windows vCenter Server 6.0 管理平台及 vSphere ESXi 虛擬化平台,後續才能順利執行遷移任務。

為何不直接在 Windows vCenter Server 主機上,而必須在另一台工作站主機上執行 VMware Migration Tools? 因為,在遷移過程中當 vCSA 6.7 管理平台欲取代 Windows vCenter Server 時,將會把 Windows vCenter Server 關機,所以必須於另一台工作站主機上執行 VMware Migration Tools,以避免屆時遷移工作任務執行中斷。

此外,考量屆時遷移 Windows vCenter Server 資料庫及組態設定資料量龐大,在網路傳輸的部份建議至少有

專屬 1 Gbps網路環境,倘若具備 10 Gbps 網路頻寬更可有效降低整體的遷移時間(如圖 10 所示)。同時,在儲存資源方面也建議來源端及目的端的 vCenter Server,能夠「

分開」使用不同的 Datastore 儲存資源,以避免因為遷移作業產生的大量 IOPS 讓儲存資源吃緊。

圖 10、vCenter Server 管理平台遷移運作示意圖

順利掛載 vCSA 6.7 ISO 映像檔後,請執行「

D:\vcsa-ui-installer\win32\installer.exe」(本文實作環境光碟機為 D 槽)。此時,系統將會開啟 vCenter Server Appliance Installer 精靈視窗,在本文實作環境中是將原有的 Windows vCenter Server 管理平台,遷移至 vCenter Server Appliance 管理平台,因此請選擇「

Migrate」項目(如圖 11 所示)。

事實上,VMware Migrate Tools 操作介面支援多國語系,例如,日語、法語、正體中文……等。但本文實作環境皆採用英文語系,所以保持預設的英文語系操作介面即可。

圖 11、在另一台主機上執行 VMware Migration Tools 準備實際執行遷移作業

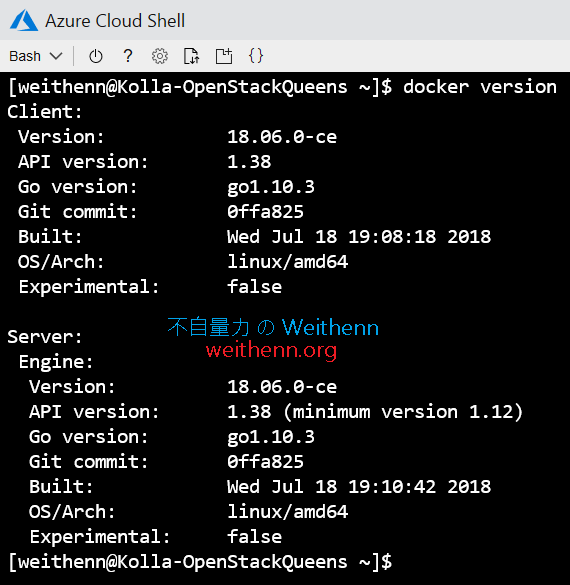

在遷移階段 1 的工作任務中,遷移工具共有 9 個選項必須與管理人員進行互動,第 1 項為系統再次說明 vCSA 6.7 的遷移工具僅支援 vCenter Server 6.0 與 6.5 管理平台版本,第 2 項則是 EULA 使用者授權條款。

第 3 項,則是連接至來源端 Windows vCenter Server 6.0 主機的相關資訊,例如,

vCenter Server 的 FQDN 名稱、指定運作中的 Migration Assistant 連接埠、預設的 Administrator@vsphere.local 管理者帳號及密碼(如圖 12 所示),順利通過檢查作業後將會顯示 vCenter Server 的 SSL 憑證指紋資訊。

圖 12、來源端 Windows vCenter Server 6.0 主機相關資訊

第 4 項則是新版 vCSA 6.7 管理平台,屆時要部署在哪台 ESXi 虛擬化平台上,以及該台 ESXi 虛擬化平台的管理者帳號及密碼和 HTTPS 連接埠。在本文實作環境中,屆時新版 vCSA 6.7 管理平台將會部署於名稱為「

esxi6-01.vsphere.weithenn.org」的 ESXi 虛擬化平台上(如圖 13 所示),同樣的通過檢查作業後將會顯示 ESXi 虛擬化平台的 SSL 憑證指紋資訊。

圖 13、新版 vCSA 6.7 管理平台將部署於 esxi6-01.vsphere.weithenn.org 虛擬化平台上

第 5 項,為指定部署的 vCSA 6.7 管理平台虛擬主機名稱及管理者密碼,在本文實作環境中指定 vCSA 6.7 管理平台虛擬主機名稱為「

vCSA67」。第 6 項,則是指定 vCSA 所要採用的規模大小,舉例來說,當 vCSA 所要管理的 vSphere 虛擬化基礎架構,ESXi 主機在 100 台以內而 VM 虛擬主機在 1,000 台以內時,那麼建議採用 4 vCPU 及 16GB vRAM 配置的 Small 規格即可。在本文實作環境中,為研發測試環境所以採用 2 vCPU 及 10GB vRAM 配置的最小規格「

Tiny」即可。

有關 vCSA 硬體資源需求的詳細資訊,請參考 VMware KB2106572 - Minimum requirements for the VMware vCenter Server 6 Appliance即可。

第 7 項,指定將 vCSA 6.7 管理平台部署於哪個 Datastore 儲存資源中。第 8 項,則是指定 vCSA 6.7 管理平台的網路組態,例如,要連接至哪個 vSwitch 虛擬交換器的 Port Group 。值得注意的是,這裡指定 vCSA 6.7 使用的 IP 位址為「

臨時」使用的 IP 位址(本文實作環境指定為

10.10.75.67),也就是只有在遷移過程中使用而已,待屆時遷移作業完成後將直接使用並取代

原有 Windows vCenter Server 6.0的 IP 位址(本文實作環境為

10.10.75.30)。最後,相關資訊確認無誤後按下 Finish 鈕,執行第 1 階段的 vCenter Server 遷移工作任務(如圖 14 所示)。

圖 14、執行第 1 階段的 vCenter Server 遷移工作任務

此時,系統將會依據剛才遷移流程中與管理人員互動的選項內容,執行部署 vCSA 6.7 管理平台的工作任務,待 vCSA 6.7 管理平台部署作業執行完畢後(如圖 15 所示),便會通知管理人員準備執行遷移流程的第 2 階段,匯出舊有 Windows vCenter Server 資料並遷移至 vCSA 6.7 管理平台。

圖 15、第 1 階段遷移任務執行完畢 vCSA 6.7 管理平台部署完成

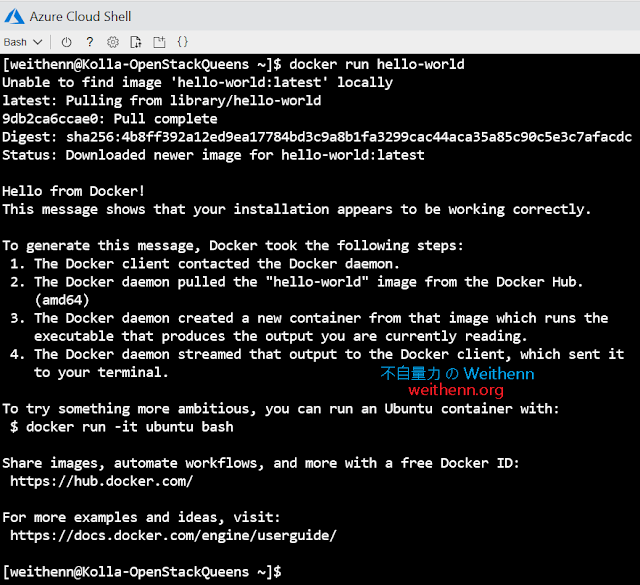

遷移階段 2、匯出 / 匯入 vCenter Server 資料庫及組態設定

順利完成第 1 階段遷移任務部署好 vCSA 6.7 管理平台後,接著便是進入第 2 階段將現有 Windows vCenter Server 資料進行遷移。

在遷移階段 2 的工作任務當中,遷移工具共有 5 個選項必須與管理人員進行互動,第 1 項也是再次說明 vCSA 6.7 的遷移工具僅支援 vCenter Server 6.0 與 6.5 管理平台版本。第 2 項,則是指定要「

匯出」資料的

Windows vCenter Server 6.0管理平台資訊,例如,

vCenter Server 的 FQDN 名稱、Migration Assistant 連接埠、Administrator@vsphere.local 管理者帳號及密碼(如圖 16 所示)。

圖 16、指定要匯出資料的 Windows vCenter Server 6.0 管理平台資訊

因為遷移工具偵測到來源端的 Windows vCenter Server 6.0 管理平台,處於 Windows AD 網域環境並且為成員伺服器,所以新增第 3 項為 vCSA 管理平台指定網域資訊(如圖 17 所示)。值得注意的是,在此選項中鍵入的網域帳號必須具備加入 vCSA 主機至 Windows AD 網域的權限之外,在網域管理者帳號的部分「

只需」鍵入使用者帳號即可,而無須在使用者帳號前加上 NetBIOS 網域名稱。

此時,遷移工具與管理人員的互動選項總數,將會由原本的 5 項變更為 6 項。

圖 17、鍵入的網域帳號必須具備加入 vCSA 主機至 Windows AD 網域的權限

第 4 項,為指定 Windows vCenter Server 6.0 管理平台要匯出哪些資料(如圖 18 所示),值得注意的是一旦選擇僅遷移及匯出部分資料的話,後續倘若需要其它資料時則無法進行遷移。舉例來說,假設僅選擇匯出

「組態設定」(Configuration)資料,雖然可以有效縮短匯出及進行遷移的時間,但是後續若需要 VM 虛擬主機運作效能歷史資料時將無法進行遷移。

倘若,Windows vCenter Server 6.0 歷史資料過多導致資料量龐大,可以考慮清除舊有資料後再執行匯出和遷移工作任務,詳細資訊請參考 VMware KB1025914 - Purging old data from the database used by vCenter Server文章。

圖 18、建議匯出並遷移現有 Windows vCenter Server 所有資料

第 5 項,詢問管理人員是否要加入 VMware CEIP 使用者體驗計畫中。最後,在第 6 項中除了顯示剛才所有的互動選項內容之外,系統也再次提醒管理人員是否已經「

備份」來源端 Windows vCenter Server 所有資料,相關資訊確認無誤後請按下 Finish 鈕,執行第二階段 Windows vCenter Server 資料遷移工作任務(如圖 19 所示)。

圖 19、執行第二階段 Windows vCenter Server 資料遷移工作任務

當遷移工具,順利將來源端 Windows vCenter Server 所有資料匯出並遷移後,此時便會將

來源端的 Windows vCenter Server進行

「關機」(Shutdown)的動作(如圖 20 所示),這就是遷移工具不應在來源端 Windows vCenter Server 上執行的原因。

圖 20、所有資料匯出並遷移後將 Windows vCenter Server 關機

當第 2 階段 Windows vCenter Server 資料遷移工作任務執行完成後,系統便會顯示連線至新版 vCSA 6.7 管理平台的網址(如圖 21 所示),可以看到跟原本的 Windows vCenter Server 主機 FQDN 相同(同時,IP 位址也已經進行取代)表示遷移完成。

那麼匯出並遷移 Windows vCenter Server 資料究竟需要多久時間 ?原則上,必須視 vCenter Server 資料量、網路傳輸速度、儲存資源及儲存效能 IOPS……等諸多因素而定,詳細資訊請參考 VMware KB2146420 - Estimating vCenter Server 5.5 to vCenter Server Appliance 6.0 migration time、VMware KB2147711 - Estimating the time for migration of vCenter Server 5.5 or 6.0 to vCenter Server Appliance 6.5文章。

圖 21、順利將 Windows vCenter Server 6.0 遷移至新版 vCSA 6.7 管理平台

採用 HTML5 或 FLEX 管理介面?

點選新版 vCSA 6.7 管理平台網址後,將會看到系統提示管理人員欲使用哪個管理介面,倘若點選「

vSphere Web Client(FLEX)」選項,表示使用舊有

Flash 技術的管理介面,若點選「

vSphere Client(HTML5)」選項,則是採用新興

HTML5 技術所開發的管理介面(如圖 22 所示)。

圖 22、採用舊有 Flash 技術或新興 HTML5 技術所開發的管理介面

管理人員倘若尚未熟悉新興

HTML5技術所開發的管理介面,仍然可以使用舊有 Flash 技術的管理介面繼續管理 VMware vSphere 虛擬化架構。然而,在最新的

vSphere 6.7版本當中,VMware 官方已經正式宣佈這是

最後一版包含 vSphere Web Client(Flash)的版本,表示後續推出的 vSphere 新版僅有新興 HTML5 技術所開發的管理介面,所以管理人員理應趁早熟悉 HTML5 管理介面才是(如圖 23 所示)。

在新版 vSphere 6.7版本當中,HTML 5 管理介面的功能性已經達到 90% ~ 95%的完整性,後續推出的新版本中將能夠完全管理 VMware vSphere 虛擬化基礎架構。

圖 23、採用新興 HTML5 技術所開發的管理介面

VAMI 和 Clarity UI 提供良好 vCSA 管理體驗

事實上,某些企業及組織當中的管理人員,由於不熟悉 SUSE Linux 作業系統所以才未部署 vCSA 管理平台,因此 VMware 官方也開始針對 vCSA 管理平台,推出專用的

VAMI(vSphere Appliance Management Interface)管理介面,搭配整合 UX Guidelines、HTML/CSS Framework 和 Angular 技術的

Clarity UI協同運作,讓管理人員能夠有最佳的 vCSA 資源管理操作體驗。

只要管理人員開啟瀏覽器,鍵入 vCSA 6.7 管理平台的 FQDN 及 VAMI 管理介面的「

Port 5480」連接埠,便可以看到 vCSA 管理平台的 VAMI 管理介面,在登入頁面中鍵入 vCSA 管理平台的管理者帳號及密碼即可登入。

登入後,在 VAMI 管理介面中,管理人員便可以立即看到 vCSA 管理平台的硬體資源情況,包含 CPU、Memory、資料庫、儲存資源……等健康資訊(如圖 24 所示)。

VAMI 管理介面同樣也支援多國語系,例如,日語、法語、正體中文……等。

圖 24、透過 VAMI 管理介面輕鬆掌握 vCSA 管理平台硬體資源健康情況

結語

透過本文的說明及實作演練相信讀者已經了解,要將現有已經建置的 Windows vCenter Server 管理平台,如何遷移至新一代採用 SUSE Linux 作業系統的 vCSA 管理平台,並且輕鬆透過 VAMI 管理介面掌握 vCSA 管理平台硬體資源健康情況。